|

昨今のブームには目を見張るしかないAI技術だが,実際にゲーム開発の業務に活用しようとすると,そのハードルは決して低くないという。現在,本格的にAIを利用したゲーム開発向けサービスを提供している,ドリコムとAIQVE ONEの技術陣の発表を紹介する。

|

広がるイメージは先行するが,直接業務に使用するには難しい現状の生成AI

講演ではまず國安氏がマイクを握り,AI技術の現状について簡単にまとめた。

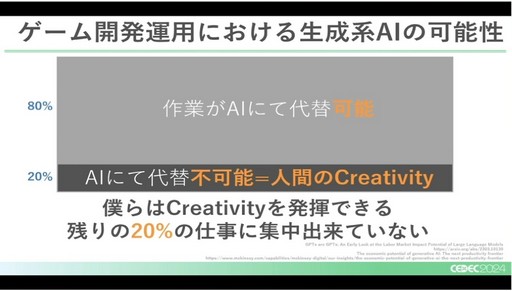

氏によると,ゲームの開発・運用でAIが代替できる作業は8割ほどだという。データはOpenAIなどの資料によるが,残りの2割が代替不可能であり,それこそが人間のクリエイティビティを発揮する分野とのことだ。言い方を変えると全体の8割のAI化できる作業に時間と労力を奪われ,残りの2割,つまり「ユーザーに良いものを届けたい」といった本来の仕事に集中できていないと語る。

|

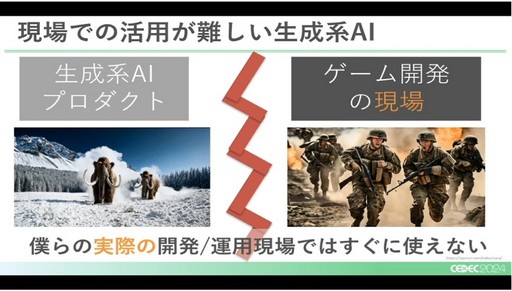

その一方で,AI側にも無視できない問題はあると國安氏。例えば動画生成AIであるOpenAIの「Sora」などは大きな注目を集めたが,ではそれがゲーム開発の現場でそのまま役立つ(使える)かと言えば,残念ながらそういった現状にはない。

|

|

また別の観点として,AIに学習させる難しさについても語った。例えば人間は失敗を繰り返すことで学んでいくが,AIはデータを通じてしか学べないので,一般的なイメージのように放置しておけば勝手に使えるように(賢く)なっていくわけではないと強調する。

|

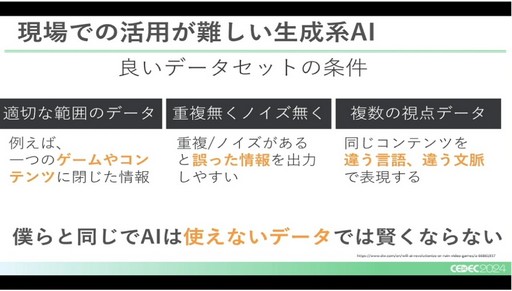

すなわちAIを(業務に適した)良い感じにするには,“良いデータ”がセットでなければならない。それは1つのコンテンツに限定した閉じたデータや,重複やノイズの少ないデータ,あるいは同じコンテンツを複数の視点(例えば複数の言語など)で見たデータである必要があるとし,端的には「使えないデータでは賢くならない」とまとめた。

|

AIを使ったQAは「魔法使いを雇う」こと?

続いてマイクを握ったのは松木氏。海外の大型タイトルと,日本のQA(デバッグ)の現状の違いから触れていった。

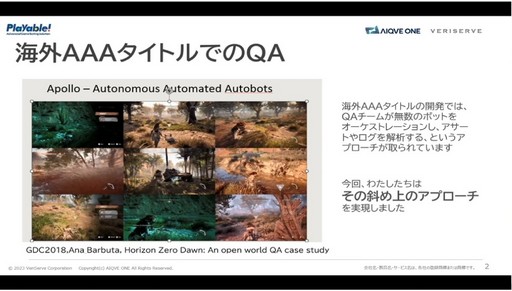

氏によると,日本のQAの環境は,海外のAAA作品などと比べると,残念ながら2周ほど遅れているのだという。具体例として,「Horizon Zero Dawn」で採用された「Apollo」(Autonomous Automated Autobots)の事例を紹介した。

簡単にApolloの仕組みをまとめると,「大量の単一行動を行うBOTを走らせ,ログや結果を解析する」といったことを行っているという。

例えばひたすら地形を走破するBOT,とにかくアイテムを集めるBOT,同じ武器で敵を倒し続けるBOT……といった感じだ。人間はそれを指揮(管理)し,解析を行う。このBOTが情報収集をする部分が,講演の冒頭で出てきたAIに置き換えられる要素の1つ,となるだろう。

|

ただし,この手法をそのまま利用できるかと言えば,日本ではなかなか難しいという。というのも,そもそもBOTを作るところからQAの仕事になっているからであり,必要なBOTを作成して運用し続けるには,それ自体にゲーム開発と変わらない十分なプログラミングの知識や技術が必要になってくるからだ。単にやれと言ってデバッグチームに放り投げても,非常に難しいのではないかとのこと。

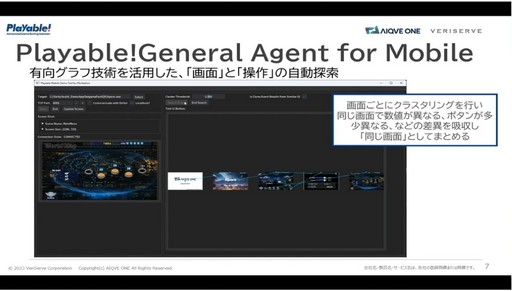

そこで氏が所属するAIQVE ONEでは,LLM(大規模言語モデル)を利用したチャットボットを使い,自然言語で3Dゲームをテストする「Playable!General Agent」というツールを作成したという。実際にそれを運用してみたところ,導入のハードルが高いなど複数の課題点が見つかり,かつ2Dゲームの開発に使いたいという声も大きかったとのことで,その後に「Playable!General Agent for Mobile」という新型を開発した。こちらは画像認識技術などによって,UIを操作する(ボタンなどを押す)ことも可能になっているそうだ。

|

|

|

こういったAI技術を採用したテストツールを活用する一番のメリットは,テストを並列化できることにあると松木氏は語る。人間が機械を操作して直接テストする場合,人間と機械の比率は“1対1”であり,それ以上増やすことはできない。

だが人間がテスト用のエージェントを“指揮”するだけでいいなら,そういった制限は一気になくなる。氏は「ちゃんとした指示,ちゃんとしたスクリプトが組めるならば」と前置きをしたうえで,100個のテストを同時に行う「超並列テスト」も可能であるとし,本来人間が直接作業行うのは,そういった最後の(指揮の)部分だけでいいはずだと強調した。

|

一方のデメリットに関しては,先ほどのPlayable!General Agent for Mobileを実案件に適用してみたところ,命令にLLMを使用している関係上,例え同じ命令を出しても,ゲーム操作をAIが試行錯誤してしまうことだ。また本来は押せないはずのボタンまで,ツール側で操作してしまったり,LLMの使用が増えるほど,APIの利用コストが上がってしまったりすることが挙げられた。とはいえ,これらの問題も技術的なものなので,ある程度解決の目処が立っているとのこと。

|

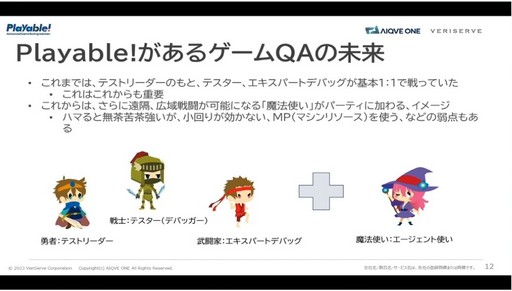

最後に松木氏はQA業務をRPGに例え,今までの人間のテスターも必要不可欠だが,それらは“肉弾戦”を行うような戦士や武闘家のような職業であるとした。それに比べてAIのツールは,遠隔や広範囲の攻撃を得意とする“魔法使い”のようなものであり,小回りも利かずにMP(マシンリソース)も消費するが,ハマると滅茶苦茶強いと語り,講演を締めくくった。

|

生成AIへ「どう指示するのか」問題

その後はディスカッションが始まり,登壇者それぞれがAIについての認識や経験について語っていたが,そのなかで松木氏が語っていたことが興味深かったので,紹介しておこう。

現在ゲームではなく,システム開発でもAIの活用が盛んに叫ばれているが,その中でも1,2を争うAI化のターゲットがドキュメントのレビューなのだという。テキストの作成なので一見,生成AIに向いていると思われがちだが,実際のところ「レビューしてください」と指示するだけでは,役に立たないボンヤリしたものしか出力されないとのことだ。

重要なのはこちらもしっかりとデータを与えることで,そのためには「私たちのレビューの基準は○○で,ドキュメントを書くうえで重要にしているのは××です。これと違うのはどこですか?」といった聞き方(指示)をしなければいけないそう。

講演の途中でも氏は,前出のとおり「ちゃんとした指示ができる前提で〜」とAIの利用について語っていた。人間に取って代わる万能なイメージが先行するAIだが,実際は二人三脚が重要なのは間違いないということだろう。

鄭重声明:本文の著作権は原作者に帰属します。記事の転載は情報の伝達のみを目的としており、投資の助言を構成するものではありません。もし侵害行為があれば、すぐにご連絡ください。修正または削除いたします。ありがとうございます。

![成功の秘訣はコミュニティ作り? 「世界で勝ち抜く:現Web3業界で求められるニーズと事業戦略」セッションレポート[WebX]](/uploads/images/20240829/3dfd9f1de71efd5c19.webp)

![台湾の天才デジタル大臣が語る,「日本のデジタル戦略」の最前線[WebX]](/uploads/images/20240829/ddf74e8ed88ae6578d.jpg)